本文目录一览:

- 1、人工智能算法歧视可能源于

- 2、AI工程师与伦理治理专家的核心职责、技能要求及学习路径详解

- 3、中国关于加强人工智能伦理治理的立场文件

- 4、怎样应对人工智能带来的伦理问题

- 5、人工智能的伦理风险及治理

人工智能算法歧视可能源于

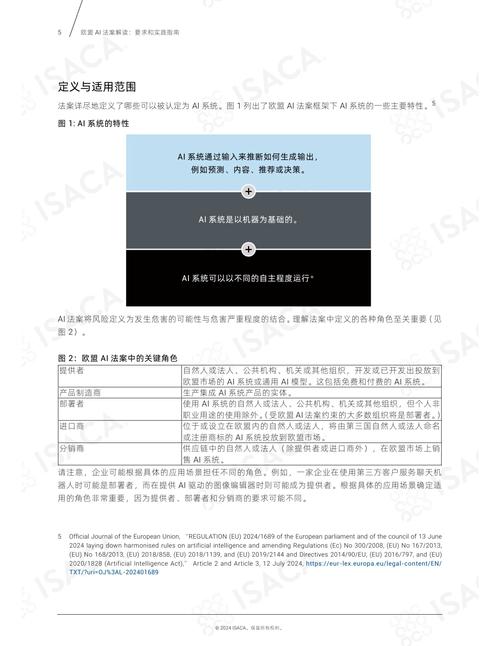

1、人工智能算法歧视可能源于算法设计的初始偏见、算法运行过程中的偏见,以及算法外部干扰导致的偏见。具体来说,可能包括以下几个方面:数据偏见:历史数据的影响:训练数据的质量对算法决策的公平性有着直接影响。

2、答案:算法歧视是指在人工智能和大数据背景下,由于算法设计、数据收集或处理过程中的偏见,导致对特定群体产生不公平对待的现象。这种歧视可能源于算法本身的逻辑缺陷、数据集的代表性不足或数据预处理中的偏见,进而在决策过程中产生对特定群体的不利影响。

3、这种偏见可能源于历史、文化、社会等多种因素,但无论如何,它们都不应该被算法所继承或放大。“黑箱”问题 除了数据集的问题外,人工智能的“黑箱”特性也是一个严峻的挑战。

4、算法歧视是一种在人工智能算法决策过程中潜在的不公正现象。算法歧视的存在:在购物推荐、就业评估、犯罪评估等多个领域,人工智能算法看似公正,实则可能隐藏着无法察觉的歧视。微软的Tay事件、图像识别软件的种族偏见,以及谷歌和亚马逊推荐系统中的不公平现象,都是算法歧视的具体案例。

5、这种歧视性结果可能源于算法对历史数据的过度依赖,以及对某些因素的错误评估。例如,在预测性警务模型中,如果历史犯罪数据主要来源于少数族裔和低收入社区,那么算法可能会对这些社区进行过度监控,从而加剧种族偏见。为了降低AI带来的歧视性影响,需要采取一系列措施。

AI工程师与伦理治理专家的核心职责、技能要求及学习路径详解

总结AI工程师需深耕技术实现与工程化能力,而伦理治理专家则需在技术、法律与伦理的交叉领域发挥作用。两者均需持续学习:工程师关注算法迭代(如GPT-5技术演进),治理专家跟踪全球政策动态(如联合国AI伦理框架)。未来,两类岗位的协同将决定AI技术的可持续发展。

AI产品经理:负责AI产品的规划、设计、推广和迭代,确保产品满足市场需求。AI提示词工程师:运用大模型技术,通过专业的prompt调试与优化,打造适配特定应用场景的智能体。AI伦理与治理类职位:AI伦理专家:研究AI技术的伦理问题,提出解决方案,确保AI技术的健康发展。

算法工程师与数据科学家:作为医疗AI的底层架构者,他们负责开发医疗影像识别、自然语言处理等模型。算法工程师需精通深度学习框架,能将病理特征转化为算法参数,而数据科学家则专注于数据的挖掘、清洗和分析,为AI模型提供高质量的数据支持。

中国关于加强人工智能伦理治理的立场文件

1、中国关于加强人工智能伦理治理的立场文件,体现了中国对人工智能伦理问题的深刻认识和高度重视。通过坚持伦理先行、加强自我约束、提倡负责任使用人工智能和鼓励国际合作等主张,中国旨在推动形成具有广泛共识的国际人工智能治理框架和标准规范,共同应对人工智能带来的全球性挑战,促进人工智能技术的健康、可持续发展。

2、建立人工智能安全监管制度 《中共中央关于进一步全面深化改革、推进中国式现代化的决定》明确提出,要建立人工智能安全监管制度。这一制度的建立,是党中央统筹发展与安全,积极应对人工智能安全风险作出的重要部署。通过加强监管,进行前瞻预防与约束引导,旨在最大限度降低人工智能可能带来的安全风险。

3、年5月,中国政府向东盟地区论坛高官会议提交了《关于加强非传统安全领域合作的中方立场文件》,对上海合作组织倡导的“互信、互利、平等、协作”新安全观进行了诠释,这是较早正式使用“非传统安全”一词的中国政府文件。

4、关于加强非传统安全领域合作的中方立场文件》,对上海合作组织倡导的“互信、互利、平等、协作”新安全观进行了诠释,这是较早正式使用“非传统安全”一词的中国政府文件。

怎样应对人工智能带来的伦理问题

应对人工智能带来的伦理问题,可以从以下几个方面入手:加强跨学科研究与合作 引入多学科视角:人工智能的发展不应仅由工程师主导,而应更多地融入哲学、伦理学、法学等社会学科的参与,形成跨学科的研究团队,共同探讨和解决人工智能带来的伦理问题。

人工智能带来的伦理问题主要包括失控风险、恶意使用、适应性风险、认知风险等,其应对措施包括建立普遍的人工智能伦理规范、推动终身学习以及鼓励创新和创意领域的发展。人工智能带来的伦理问题 失控风险:人工智能系统的自主决策能力可能导致其行为超出人类控制范围,从而引发安全风险。

AI研发人员需遵守伦理准则,建立伦理审查制度,监管算法,确保其不作恶。针对算法决策和歧视,需提供法律救济,确保透明性,并建立申诉机制。同时,跨学科的AI伦理研究应加强,确保AI与人类价值规范及需求相一致,避免设计出“像人一样具有感知、认知、决策等能力的事物”后,与人类价值观产生冲突。

人工智能面临的伦理问题主要有以下几个方面:数据隐私问题:人工智能在数据收集、存储、处理过程中,容易泄露个人隐私,这违背了个人隐私权利,也可能导致安全问题的出现。如何在确保数据隐私的前提下利用数据,是人工智能发展中需要解决的重要伦理问题。

加强AI系统的安全性和稳定性,防止恶意攻击、误导和不稳定等问题,保障人类安全和利益。促进人机对齐 推动AI技术与人类价值观的融合,确保AI系统的目标和人类价值观一致,避免产生意外的有害后果。制定和实施伦理准则 制定和完善AI伦理准则,规范AI技术的研发和应用,保障人类的利益和安全。

人工智能在发展过程中遇到了一系列伦理挑战,其中最突出的三个问题如下:首先,隐性机器歧视问题。我们越来越依赖人工智能进行日常决策,例如视频推荐、贷款审批等。尽管我们希望人工智能能够提供公平的结果,但其决策过程缺乏透明度,可能导致潜在的公平问题。我们需要审视其是否真正公正,以及如何消除这些隐患。

人工智能的伦理风险及治理

为了应对上述伦理风险,人工智能伦理治理显得尤为重要。人工智能伦理治理是指通过制定和实施一系列的规范和措施,确保人工智能技术的研发和应用符合道德和法律标准,以保障人类的利益和安全。具体治理措施包括:规范研发和应用 制定严格的研发和应用规范,确保AI技术符合道德和法律标准,避免出现偏见、歧视、隐私和信息泄露等问题。

人工智能带来的伦理问题主要包括失控风险、恶意使用、适应性风险、认知风险等,其应对措施包括建立普遍的人工智能伦理规范、推动终身学习以及鼓励创新和创意领域的发展。人工智能带来的伦理问题 失控风险:人工智能系统的自主决策能力可能导致其行为超出人类控制范围,从而引发安全风险。

中国关于加强人工智能伦理治理的立场文件,体现了中国对人工智能伦理问题的深刻认识和高度重视。

第五条:推动敏捷治理,持续优化治理机制和方式,有序推动人工智能健康和可持续发展。第六条:积极实践示范,将人工智能伦理道德融入管理全过程,及时总结推广治理经验。第七条:正确行权用权,明确职责和权力边界,保障相关主体的合法权益。

监控环节,部署动态风险评估模块,实时检测用户交互中的潜在伦理风险(如诱导性言论),并触发人工复核流程,2023年累计拦截违规操作12万次。修正机制上,公司开源了伦理干预工具包,允许开发者自定义AI行为边界,例如限制医疗机器人仅提供诊断建议而非治疗决策。

人工智能伦理治理的基本范畴主要包括数据隐私保护、算法透明度、技术滥用防范、以及符合人类价值观和道德规范的应用等。在数据隐私保护方面,人工智能伦理治理关注的是如何确保个人数据在采集、存储、使用和销毁等环节都符合隐私保护的要求,防止数据泄露和滥用。

评论列表(3条)

我是柯美号的签约作者“sxbfde”

本文概览:本文目录一览: 1、人工智能算法歧视可能源于 2、...

文章不错《算法歧视治理(AI伦理审查)(算法歧视是什么)》内容很有帮助